La Modélisation de données pour la détection de criminalité financière dans les assurances

Le secteur de l’assurance est actuellement confronté à une menace grandissante : la criminalité financière. Les défis complexes du blanchiment d’argent et du financement du terrorisme planent comme une épée de Damoclès sur cette industrie. Face à ces menaces croissantes, les compagnies d’assurances se tournent de plus en plus vers la modélisation de données, une méthodologie sophistiquée qui mobilise des algorithmes de pointe pour scruter les moindres recoins de leurs activités et détecter les signes de toute activité suspecte.

Dans cet article approfondi, nous explorerons en détail la modélisation de données pour la détection de la criminalité financière dans le domaine des assurances.

Qu'est-ce que la modélisation de données en assurance et sa nécessité pour la conformité LCB-FT?

La modélisation de données est une discipline avancée qui repose sur l’utilisation de techniques statistiques et mathématiques pour créer des modèles à partir de données brutes. Dans le contexte de la détection de la criminalité financière en assurances, cela signifie analyser un large éventail de données, y compris les transactions, les profils des clients, les réclamations, les bénéficiaires, et les relations entre ces données.

Les modèles résultants sont conçus pour identifier des schémas suspects, des comportements non conformes et des anomalies.

La nécessité de la modélisation de données en assurance est particulièrement critique non seulement pour se conformer aux réglementations et lois mais aussi pour les raisons suivantes:

Détection précoce

- La modélisation de données permet une détection précoce des schémas de comportement suspects. Elle peut repérer des tendances qui passeraient inaperçues avec des méthodes de surveillance manuelle.

Gestion des risques

- En identifiant les activités suspectes, la modélisation de données permet aux compagnies d’assurances de gérer plus efficacement les risques associés à la LCB-FT.

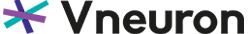

Grâce à des modèles de données sophistiqués et à l’analyse de multiples variables, les assurances peuvent non seulement détecter plus efficacement les schémas et les comportements potentiellement frauduleux, mais aussi évaluer et attribuer des scores de risque précis à chaque transaction ou client. - La modélisation de données permet ainsi de catégoriser et de classer les risques de manière plus nuancée. L’objectif est de hiérarchiser les activités à haut risque, afin de faciliter la priorisation des enquêtes et des mesures de contrôle.

Meilleure prise de décision

- La modélisation de données permet également de prendre des décisions informées basées sur des preuves, ce qui réduit les biais humains dans le processus de détection de la criminalité financière.

Modélisation des données en compagnies d’assurances: Les Algorithmes et les Types de Données Utilisés

Algorithmes de Machine Learning

Les entreprises d’assurance font souvent appel à des algorithmes de machine learning pour la détection de la criminalité financière. Parmi les techniques couramment utilisées, on trouve :

- Les modèles supervisés: tels que les arbres de décision, les forêts aléatoires et les réseaux neuronaux. Ces modèles sont formés sur des ensembles de données historiques contenant des exemples de transactions légitimes et frauduleuses tout en utilisant les informations collectées du module KYC (Know Your Customer). Cette approche repose sur l’obtention d’informations précises sur les clients, ce qui permet de distinguer de manière fiable les transactions légitimes.

- Les modèles non supervisés: se concentrent sur l’identification de schémas inattendus sans nécessiter de faire recours aux données étiquetées. Pour la détection d’anomalies, les données de surveillance des transactions sont les plus utilisées, dont l’objectif est de repérer des schémas inhabituels dans les transactions qui pourraient indiquer des activités de blanchiment d’argent ou de financement du terrorisme.

Données Structurées et Non Structurées

- Les données structurées incluent les informations telles que les montants de transactions, les dates et les codes.Les données structurées sont souvent liées aux modules Transaction Monitoring et Filtrage pour détecter des transactions suspectes ou des correspondances avec des listes GDA/PPE.

- Les données non structurées, telles que les textes, les documents, les courriels et d’autres informations, peuvent contenir des indices sur la criminalité financière et doivent être intégrées dans le processus de modélisation: Les données non structurées peuvent être analysées à l’aide de technologies de traitement du langage naturel (NLP) et sont souvent utilisées aussi en combinaison avec les modules Transaction Monitoring et Filtrage.

Données Temporelles

- Les données temporelles jouent un rôle essentiel dans la modélisation des données. Les modèles doivent tenir compte de la chronologie des événements pour identifier les schémas suspects qui se développent au fil du temps. Les données temporelles sont aussi essentielles pour le module surveillance des transactions, car elles permettent de détecter les schémas suspects qui évoluent dans le temps.

- Après avoir exploré l’univers complexe des algorithmes et technologies de Machine Learning quelles sont alors les étapes nécessaires pour mettre en place le processus de modélisation des données.

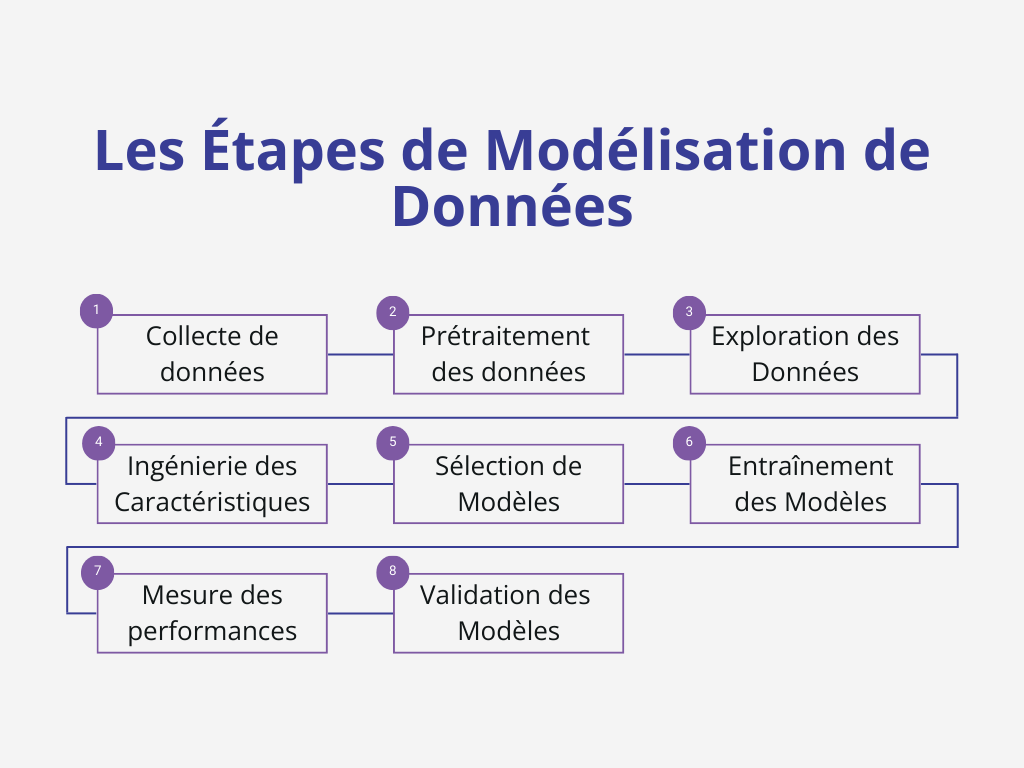

Les Étapes de Modélisation de Données pour la Détection de Criminalité Financière dans les compagnies d’assurances

La modélisation de données pour la détection de la criminalité financière dans les assurances comporte plusieurs étapes cruciales qui se présentent comme suit:

1. Collecte de données

La collecte de données représente la première étape essentielle de ce processus. Les assurances doivent rassembler des données complètes et pertinentes en provenance de sources multiples, incluant les systèmes internes et les bases de données externes. Cette collecte englobe à la fois des données structurées telles que les transactions, les montants et les dates, et des données non structurées comprenant des textes, des documents et des médias sociaux.

2. Prétraitement des données

Avant d’entamer l’analyse des données, il est impératif de les prétraiter. Cette étape comprend le nettoyage, la normalisation et la transformation des données afin de les rendre utilisables. La gestion des données manquantes, la suppression des doublons et le traitement des valeurs aberrantes sont des aspects cruciaux de cette phase. Le prétraitement est essentiel pour garantir la qualité des données utilisées dans le modèle.

3. Exploration des Données

L’exploration des données consiste en une analyse approfondie visant à identifier des tendances, des corrélations, des schémas et des comportements inhabituels. Cette étape s’appuie à la fois sur des données structurées et non structurées. Elle révèle souvent des indices cruciaux sur les activités suspectes, contribuant ainsi à une meilleure compréhension de la situation.

4. Ingénierie des Caractéristiques

L’ingénierie des caractéristiques est un processus consistant à créer de nouvelles variables ou caractéristiques à partir des données existantes. Ces caractéristiques additionnelles peuvent améliorer les performances des modèles en fournissant des informations pertinentes pour la détection de la fraude et des risques financiers. Cette phase nécessite une manipulation astucieuse des données pour extraire des informations utiles.

5. Sélection de Modèles

Le choix des algorithmes de modélisation appropriés dépend des caractéristiques des données et des objectifs spécifiques de détection. Étant donné l’influence des différents types de données, les entreprises d’assurance doivent évaluer les performances de divers modèles pour sélectionner l’approche la plus adaptée à leur contexte.

6. Entraînement des Modèles

Les modèles de détection de la criminalité financière doivent être formés en utilisant des données historiques étiquetées, c’est-à-dire des données contenant des exemples de transactions légitimes et frauduleuses. Pendant la phase d’entraînement, les modèles apprennent à identifier les schémas de comportement suspects en utilisant à la fois des données structurées et non structurées.

7. La Validation des Modèles de Données

Après l’entraînement, les modèles doivent être rigoureusement évalués. Cette étape implique de tester les modèles sur des données de validation indépendantes pour mesurer leur performance. Des métriques de performance telles que la précision, le rappel, la spécificité et la courbe ROC sont utilisés pour évaluer l’efficacité des modèles dans la détection de la criminalité financière.

Les deux méthodes de validation qui sont les plus utilisées sont les suivantes :

7.1. Validation Croisée

La validation croisée, également connue sous le nom de cross-validation, est une technique fondamentale. Elle implique la division des données en plusieurs ensembles de formations et de tests. Les modèles sont formés et testés de manière itérative sur ces ensembles, permettant ainsi d’évaluer leur performance dans des conditions variées. Cette méthode avancée permet de s’assurer que les modèles sont capables de généraliser efficacement à différents scénarios.

7.2. Jeux de Données de Test Indépendants

Afin d’éviter le surajustement (overfitting) des modèles aux données d’entraînement, des jeux de données de test indépendants sont rigoureusement employés. Ces jeux de données n’ont pas été utilisés lors de la phase d’entraînement des modèles. Ils servent à mesurer la capacité des modèles à généraliser à de nouvelles données, simulant ainsi des situations réelles de détection de la criminalité financière.

8. Mesurer la performance des modèles

Après avoir validé les modèles, il est nécessaire de mesurer leurs performances et leurs taux d’erreur, les métriques à suivre se présente comme suit :

- Matrice de confusion : Cette matrice permet de visualiser les performances du modèle en termes de vrais positifs (cas réels correctement identifiés), de vrais négatifs (cas réels correctement rejetés), de faux positifs (cas non réels incorrectement identifiés comme positifs) et de faux négatifs (cas réels incorrectement rejetés).

- Courbe ROC (Receiver Operating Characteristic) : Cette courbe offre un aperçu détaillé de la sensibilité du modèle à différentes valeurs de seuil. Elle montre la capacité du modèle à distinguer entre les classes positives et négatives, en mesurant le taux de vrais positifs par rapport au taux de faux positifs.

- Le taux de précision : La précision mesure la proportion de prédictions positives du modèle qui étaient correctes. Elle permet de quantifier la fiabilité des prédictions positives.

Formule : Précision = (Vrais Positifs) / (Vrais Positifs + Faux Positifs) - Le taux de rappel : Le rappel mesure la proportion de cas réels positifs qui ont été correctement identifiés par le modèle. Il évalue la capacité du modèle à détecter l’ensemble des cas positifs.

Formule : Rappel = (Vrais Positifs) / (Vrais Positifs + Faux Négatifs) - Le taux de Spécificité : La spécificité évalue la capacité du modèle à identifier correctement les cas réels négatifs. Elle mesure la proportion de cas négatifs réels correctement identifiés.

Formule : Spécificité = (Vrais Négatifs) / (Vrais Négatifs + Faux Positifs)

N’ayez pas d’inquiétude, vous n’aurez pas à effectuer ces calculs vous-même. Votre dispositif LCB-FT vous fournira les chiffres exacts dont vous avez besoin en temps réel.

Maintenant, une fois que les modèles sont mis en place, la prochaine étape réside dans la création de scénarios concrets en vue de l’application de ces modèles.

Création de Scénarios à partir de la Modélisation de Données

Les scénarios sont des configurations hypothétiques ou réelles qui permettent aux assureurs de mettre en pratique les informations extrapolées de la modélisation de données et de déclencher des actions appropriées en cas de détection d’activités potentiellement suspectes.

Ci-dessous une présentation simplifiée des étapes nécessaires à la création de scénarios :

1. Identification des Scénarios :

Le début du processus de création de scénarios dépend de l’identification des contextes susceptibles de favoriser l’apparition de la fraude ou du financement du terrorisme. Cette phase pourrait englober des scénarios articulés autour des catégories de délits financiers, notamment le blanchiment d’argent/ financement de terrorisme au moyen de polices d’assurance frauduleuses. Une collaboration étroite avec des experts sectoriels s’avère fondamentale pour garantir la pertinence de ces scénarios.

2. Développement Approfondi des Scénarios :

Une fois les scénarios identifiés, il convient de les développer d’une manière plus détaillée et plus approfondie. Cela implique de décrire en détail les circonstances, les parties prenantes, les transactions potentielles et les comportements suspects associés à chaque scénario. Les données dérivées de la modélisation servent de socle solide pour définir les caractéristiques clés de chaque scénario.

Il est impératif de concevoir des scénarios dynamiques et évolutifs qui s’adaptent au fil du temps et aux nouvelles tendances en matière de criminalité financière.

3. Intégration dans les Processus Opérationnels :

Une fois les scénarios définis et validés, leur intégration au sein des processus opérationnels de l’assurance s’avère primordiale. Cette dernière étape peut englober la mise en place d’alertes automatisées générées par les modèles lorsqu’un cas réel correspond à un scénario donné. Il faut noter que les équipes dédiées à la conformité et à la sécurité doivent être formées afin de réagir de manière adéquate à ces alertes.

Bien que la modélisation de données joue un rôle crucial dans la détection de la criminalité financière en assurance, il est impératif de reconnaître que ce processus peut s’avérer frustrant, chronophage et parfois peu pratique à répéter à chaque nouvelle menace émergente. La quantité de données à traiter et la complexité croissante des modèles nécessaires pour suivre l’évolution des schémas de blanchiment d’argent et de financement de terrorisme rendent ce processus extrêmement difficile.

C’est pourquoi il est important de s’appuyer sur des modèles packagés et des solutions spécialisées telles que celles proposées par Vneuron. Ces modèles pré-entrainés sont spécialement conçus pour détecter les menaces et les activités suspicieuses les plus complexes. Ils tiennent compte de divers aspects opérationnels de l’assurance, tels que les clients, les polices d’assurance, les sanctions, etc. De plus, l’automatisation joue un rôle crucial dans l’efficacité de ces solutions.

Les solutions de Vneuron permettent d’automatiser une grande partie du processus de modélisation des données en utilisant les algorithmes et les technologies mentionnées auparavant tout en permettent l’intégration des workflows collaboratifs et personnalisés. Cela signifie que les tâches qui étaient autrefois manuelles et chronophages, telles que l’analyse de vastes ensembles de données, la recherche de schémas complexes et la vérification des transactions, peuvent désormais être effectuées rapidement et de manière efficace en temps réel.

En intégrant la modélisation de données, dans votre stratégie de lutte contre la criminalité financière en assurance, vous pouvez non seulement renforcer la conformité aux réglementations, mais également améliorer la prise de décision, réduire les biais humains et protéger la réputation de votre entreprise.

N’avez-vous pas encore trouvé le dispositif LCB-FT le plus adapté à votre activité assurantielle ? Nous pouvons vous aider !